Inteligencia Artificial, un tren bala ¿hacia qué destino?

Sus ventajas son muchas, pero existe un gran debate sobre el gran impacto social que puede generar, y voces muy relevantes exigen poner puertas al campo y evitar su uso indebido

Los grandes volúmenes y variedad de datos que se generan y recopilan hacen de la Inteligencia Artificial un actor invisible y determinante para el devenir de personas, empresas y países.

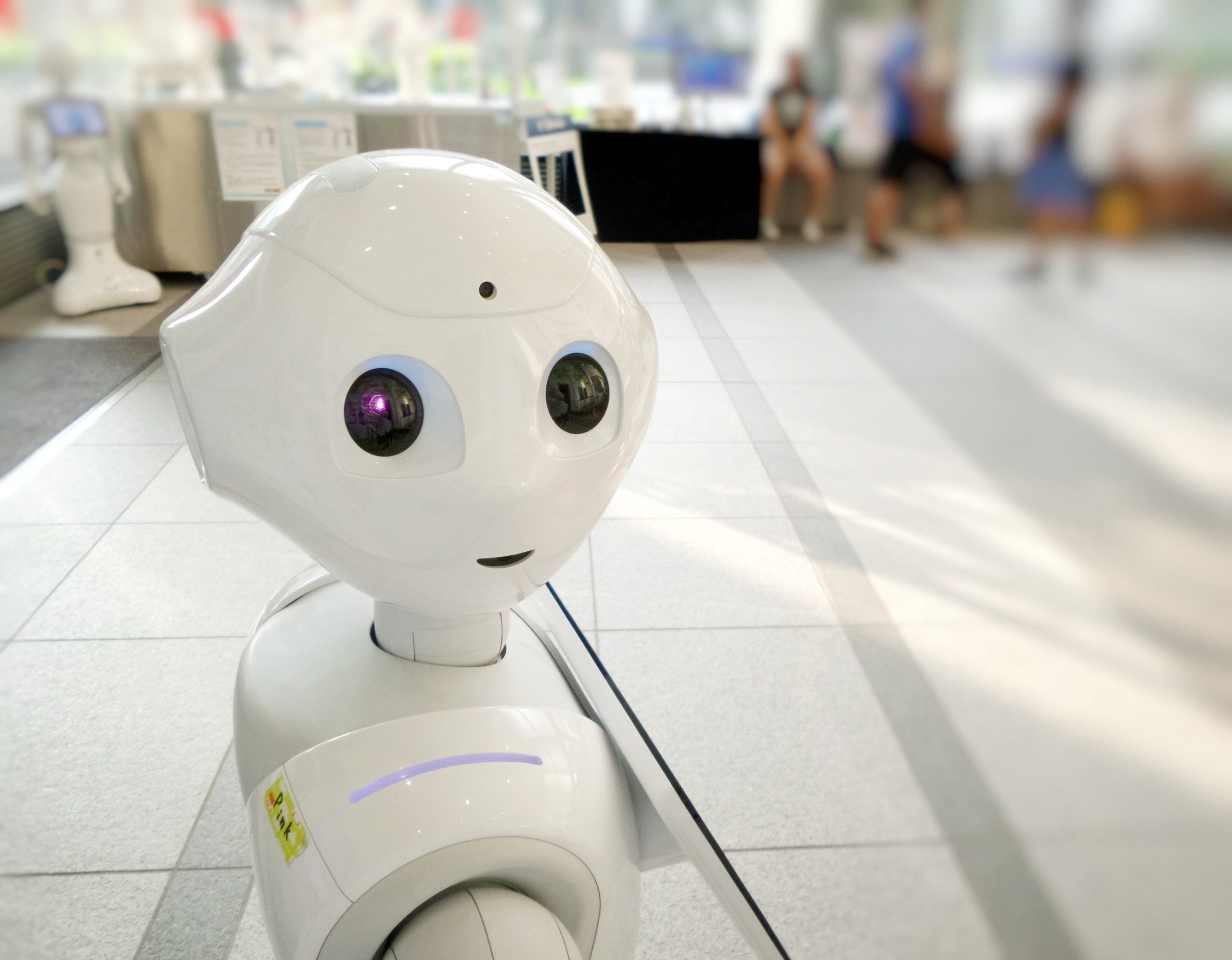

La IA ha cambiado el modo en cómo nos relacionamos con la tecnología y el papel que juega en nuestro día a día. Los chatbots se han popularizado e incorporan ya habilidades como la empatía o el conocimiento; se comercializan confidentes personales como Replika con el que compartir, sin juicios, los pensamientos y sentimientos; aparecen estrellas musicales de realidad virtual, como Hatsune Miku y podríamos seguir con soluciones que, a cambio de nuestros datos, nos hacen, inicialmente, la vida más fácil.

Numerosas empresas están incorporando IA para mejorar y agilizar sus procesos internos, predecir comportamientos de clientes, desarrollar nuevos productos, facilitar o tomar directamente decisiones para adaptarse al entorno. La pandemia ha sido un revulsivo para esta tecnología en todos los sectores, no sólo en el tecnológico.

Se ha incorporado a la agenda de las principales compañías, e irá ganando progresivamente terreno en todas las áreas funcionales de la empresa. La consultora IDC estima que la inversión en Inteligencia Artificial en Europa llegará este año a los 12.000 millones de dólares y que continuará creciendo de manera sólida por encima del 10 por ciento hasta 2024.

Los gobiernos también están avanzando en su implantación, con los países asiáticos a la cabeza. La IA apoya el rediseño de los procesos internos de la administración pública y los mecanismos de formulación de políticas, con el fin de mejorar la calidad de los servicios públicos y el compromiso con los ciudadanos.

En principio, el uso y desarrollo de esta tecnología debería ser positivo para la sociedad. Sin embargo, su aplicación y velocidad de desarrollo debe ser explorada de forma reflexiva, analizando todos los impactos asociados. Así, los procesos de decisión basados en IA pueden determinar quién recibe o no determinados servicios, ayudas públicas, o quién puede acceder o no a un empleo, a una beca, disfrutar de la libertad condicional, …

Esta capacidad de decisión y el papel que juegan tanto gobiernos como empresas es motivo de un intenso debate a nivel internacional. Tal es así, que la alta comisionada para los derechos humanos de la ONU, Michelle Bachelet, pidió el mes pasado una moratoria parcial en el uso y venta de esta tecnología, hasta que se hayan puesto las salvaguardas adecuadas.

Es decir, disponer de una correcta evaluación de riesgos, impactos y cómo mitigarlos o evitarlos, la base de todo proceso de debida diligencia.

Se habla de riesgos con alto impacto social y económico como el futuro de los puestos de trabajo, las violaciones de privacidad y libertad de expresión, la confusión y manipulación a través de Deepfakes, la toma de decisiones sesgadas o incorrectas, el aumento de la desigualdad o por último, haciendo eco a la preocupación de Elon Musk, la puesta en peligro de la seguridad física a través de las armas letales autónomas.

Hawking, Musk, Wozniak y Gates alertan de los riesgos

Stephen Hawking, Elon Musk, Steve Wozniak, Bill Gates y muchos otros grandes nombres de la ciencia y la tecnología han mostrado su preocupación sobre los riesgos que entraña un uso indebido de la IA.

Recientemente Elon Musk declaraba que la IA es más peligrosa que las armas nucleares puesto que es capaz de hacer mucho más de lo que casi nadie sabe, y la tasa de mejora es exponencial. “A menos que aprendamos a prepararnos y evitar los riesgos potenciales, la IA podría ser el peor acontecimiento en la historia de nuestra civilización ".

Actualmente no existe un marco o ley de gobernanza global en materia de IA. Los países que compiten por el dominio de esta tecnología son Estados Unidos y China.

El primero, junto con Europa, se centra en un desarrollo de una IA humanista, teniendo en cuenta aspectos como la ética y la privacidad de las personas. Sin embargo, el segundo está apostando de manera más ambiciosa, por el utilitarismo y por maximizar el beneficio, a través de sus empresas más punteras como son Alibaba, Baidu y Tencent. Esta última propietaria de WeChat, que ofrece servicios de mensajería, redes sociales y pagos online a la que accede también el Gobierno chino para vigilar a sus ciudadanos.

En este contexto, ¿en qué factores deberíamos trabajar para disponer de los beneficios de la IA, sin generar riesgos de alto impacto?

Hay tres aspectos clave a controlar, más allá de disponer, como es natural, de una tecnología robusta, segura y confiable:

- La ética: La IA debe estar plenamente centrada en el ser humano, considerando todos sus impactos potenciales.

¿Qué organizaciones deberían analizar estos impactos? Todas. Desde las que desarrollan, comercializan, usan… e incluso invierten. Este último punto no es baladí.

Tal vez, se haga necesario incorporar a los criterios de exclusión de los inversores determinados usos o aplicaciones de IA, especialmente todas aquellas asociadas a las violaciones de derechos humanos, como las relacionadas con el desarrollo de armas letales autónomas.

No es una idea a futuro, es algo que está pasando ya y las empresas e inversores tendrán que tomar posición. Ejemplo de ello es que Amazon, IBM o Microsoft suspendieron la venta de sistemas de reconocimiento facial a la policía a raíz de las protestas por la muerte de George Floyd.

- El respeto a la regulación en la materia. Es necesario establecer unos límites o un marco común a nivel mundial como propone la ONU.

¿En qué momento nos encontramos? Estamos en una fase muy inicial y su construcción será compleja, pues partimos de los marcos y valores diferentes en cada país. Europa, defensora del bienestar, es la primera región que contará con una regulación sobre Inteligencia Artificial y Robots, que se prevé entre en vigor en 2023. El reglamento busca acompasar la seguridad y fortalecer la inversión en IA, estableciendo varios niveles de riesgo. Además, ha lanzado la iniciativa AI Watch, para supervisar y facilitar la aplicación de la Estrategia Europea en esta tecnología.

- La transparencia y auditoría de procesos. Este último punto es fundamental, especialmente cuando la IA en muchos casos es casi indetectable.

¿Qué está ocurriendo? Las empresas, en general, no informan sobre sus procesos automatizados de decisión y ni de cómo los entrenan o auditan los algoritmos en los que se basan.

Ciudades como Ámsterdam y Helsinki ya cuentan con un registro de algoritmos

A nivel público, la situación es similar, aunque ya hay ciudades como Ámsterdam y Helsinki que cuentan con un registro de algoritmos, que buscan mejorar la confianza ciudadana en la IA.

En España, la Secretaría de Estado de Digitalización e Inteligencia Artificial ultima el lanzamiento del Observatorio Nacional del Impacto Social de los Algoritmos, y ha postulado a nuestro país como banco de pruebas del Reglamento Europeo de la Inteligencia Artificial, lo que conlleva que el Reglamento podría estar en funcionamiento en España en 2022.

El tercer sector también comparte la preocupación por el sesgo e impacto de los algoritmos. Así, Éticas Foundation ha presentado recientemente el Observatorio de Algoritmos con Impacto Social (OASI), un buscador que permite conocer más sobre los algoritmos que toman decisiones de manera automatizada que afectan a personas de todo el mundo.

El respeto de estos factores clave gana todavía más relevancia a medida que la IA va evolucionando y aumentando la capacidad de entendimiento del entorno.

Como en todas las revoluciones, la tecnología va por delante de normas y de reflexiones sobre el impacto provocado. Por ello, éste es un ámbito donde, con el fin de garantizar el respeto de las tres claves enumeradas anteriormente, la colaboración se ha de dar también a tres bandas: empresas, gobiernos y sociedad, porque sin duda todos viajamos en el mismo tren… y… ¡el tren no espera!